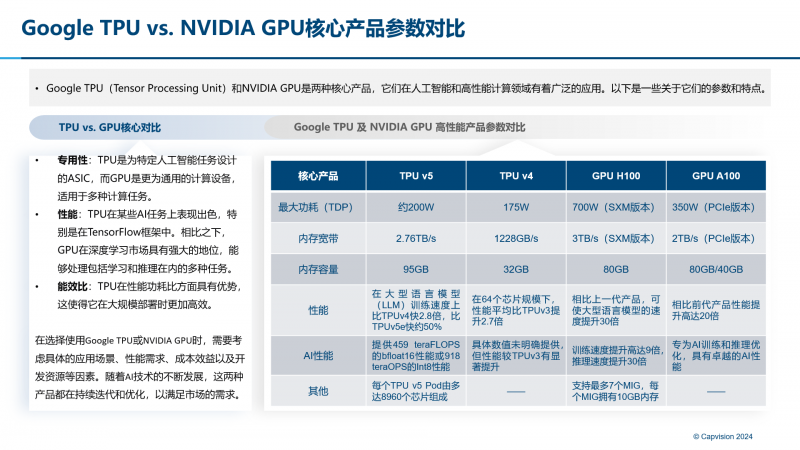

“今年全球开发者大会(WWDC)期间,Apple公布的技术论文《Apple Intelligence Foundation Language Models》中介绍了给Apple Intelligence提供支持的两个模型——AFM-on-device和AFM-server,同时为了训练这两款AI模型,Apple使用了Google最新的两款TPU,并组成大型芯片集群(TPU+GPU),而非选择市场主流的NVIDIA GPU,此举引起了业内外极大的关注。”

引言:

Apple每年9月的新品发布都是全科技界关注的焦点,2024年新款iPhone 16发售预告中,除了宣布引入了全新AI功能Apple Intelligence以外,同时也透露其训练的AFM模型采用了Google研发的第四代AI芯片TPUv4和更新一代的芯片TPUv5,而非NVIDIA GPU。这一选择是否会是新生态的风向标,对今后国内外市场会有怎样的影响?

一. Apple与Google在TPU算力领域合作起始于TPUv3时代

Apple整体战略部署上早年就意识到NVIDIA CUDA闭源模式弊端不利于自身生态的长远发展,自TPUv3时代便开始使用Google TPU+GPU算力,并借助JAX开源平台与CUDA底层逻辑相似性,实现快速部署迁移训练。另加之2023年全球市场N卡排队,进一步促进双方合作。

Apple对于原生系统AI布局的考量分为两方面:一是接入第三方大模型旗舰产品,赋能生态;二是通过开发和训练自己大模型直接赋能业务与原生系统。后者作为公司终极战略,Apple一直进行此方面的探索,并在更早期就与Google建立合作,从TPUv3、TPUv4时期就开始大量使用Google芯片作为模型训练的底层支撑。所以此次Apple选择TPUv5,整体的技术门槛和学习曲线要比选择其他厂商容易得多。

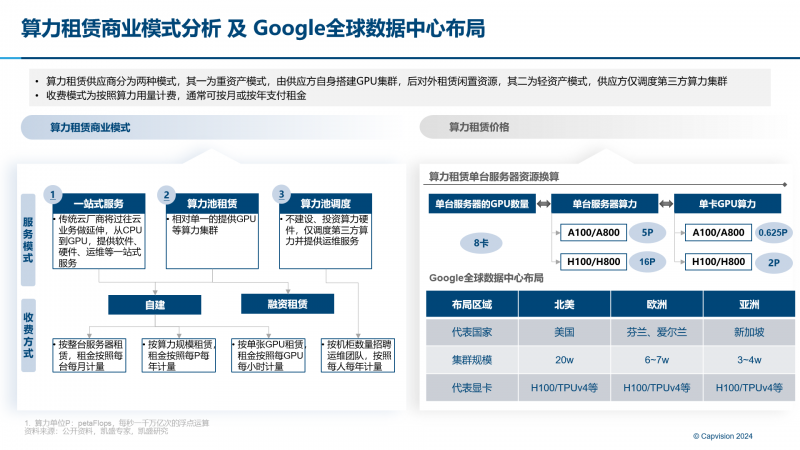

GoogleAI算力一直采用自建租赁模式。自家TPU平均每1~1.5年更新一代,其中70%~80%的算力用于内部业务场景(搜索,广告,视频,Gemini等)使用,剩余20%~30%以租赁方式供外使用,主要海外头部客户如Anthropic,cohere等AI初创公司,更不乏国内互联网大厂身影。为应对NVIDIA CUDA闭源生态垄断,Google开源的JAX以其与CUDA相似的开发框架逻辑,降低用户学习与迁移成本,实现市场突破。

二. Google进一步在全球扩张算力节点,实现商用突破,降低算力成本

Google未来将进一步在北美(万卡集群),欧洲(万卡集群),亚洲(千卡集群)进行中心+边缘节点枢纽建设。主要以公有云、专属云方式进行算力租赁。内部对于私有云售卖方案短期内不会实现突破。

主要原因为:Google对于其TPU+GPU算力集群的方案保密性及知识产权重视度高,不会轻易向第三方售卖;另外TPU+GPU集群模式的供电及液冷要求也更高,选址也是较难解决问题;后端运维暂时也无法投入过大精力进行。

未来整体商用还是以租赁为主,随着全球多个节点的建设完善,将向外界释放更多TPU算力,整体算力价格上也将帮助厂商实现降本增效,按其内部初步估算,其TPU+GPU的租赁模式,将降低客户20~30%的算力成本支出。

三. Intel、AMD、Microsoft布局智算

目前全球AI芯片市场,NVIDIA市场占有率超90%,掌握市场定价的绝对话语权。NVIDIA GPU+CUDA已成为市场AI厂商训练其通用模型最优解,如旗下H100训练大语言模型效率是CPU的300倍,而其CUDA通用平台框架也助力开发人员和用户在不同型号和连续几代GPU上运行相同的软件,实现无缝升级,简化原始开发,正在形成NVIDIA在AI领域的生态护城河。根据海外投行Raymond James数据显示,NVIDIA H100的制造成本约为3320美元,而其目前市场售价已达2.5~3万美金,实现10倍的利润。

除NVIDIA以外,Intel、AMD及Microsoft等头部厂商也继布局智算领域:

Intel Falcon Shores GPU预计将于2025年发布,属于GPU Max系列。它将采用多芯片模块化设计,最高可达288GB容量及9.8TB/s吞吐量。此外,Intel将提供通用的GPU编程接口one-API,支持CXL以实现跨架构和跨平台的兼容性。

AMD Instinct MI300系列加速器专为最苛刻的AI和HPC工作负载设计,提供卓越的计算性能、高内存密度和高带宽内存,并支持专门的数据格式。AMD首席执行官苏姿丰表示,MI300已成为AMD有史以来增长最快的产品,并且AMD将在未来分享新一代Instinct AI芯片的更多细节,最早将于2025年晚些推出。

Microsoft与AMD合作开发代号为Athena的自研AI芯片,以作为NVIDIA产品的替代方案。微软在AI芯片领域的动作反映了其对AI技术不断增长的需求,尤其是在Chat-GPT等生成式AI应用的推动下。

四. 行业影响

回顾Apple全新AI选用Google TPU芯片延续两家合作,Google TPU+GPU智算算力架构得到国内外市场进一步的认可。这些头部互联网、AI模型的大厂考虑技术多元性等因素,也不希望被单一厂商的商业模式束缚住手脚。但目前由于Google算力中心承载能力和全球节点有限,短期内不会引起行业强烈震动,但从长远角度考虑该模式持续促进算力供给端各大芯片厂商,更主要也为需求端客户选择打开了更多新的思路。